신문은 선생님

[IT 따라잡기] 57년 전 16개 단어가 고작이었는데… 곧 사투리도 척척

입력 : 2020.12.08 03:30

음성 인식

영화 '아이언맨'을 보면 주인공 토니 스타크의 인공지능 비서 '자비스'가 나옵니다. 인공지능 컴퓨터인 자비스는 스타크의 업무를 돕는 것뿐 아니라 스타크와 수다를 떨기도 합니다. 마치 인간의 감정을 이해하는 것처럼 스타크의 기분에 따라 대응하기도 하죠. 자비스는 음성인식 기술을 바탕으로 이뤄진 첨단 기술의 결정체로, 음성으로 제어하는 걸로 나오죠. 오늘은 인간과 인공지능 사이의 매개체가 되는 음성인식 기술에 대해 알아보겠습니다.

◇대화하는 음성인식 비서

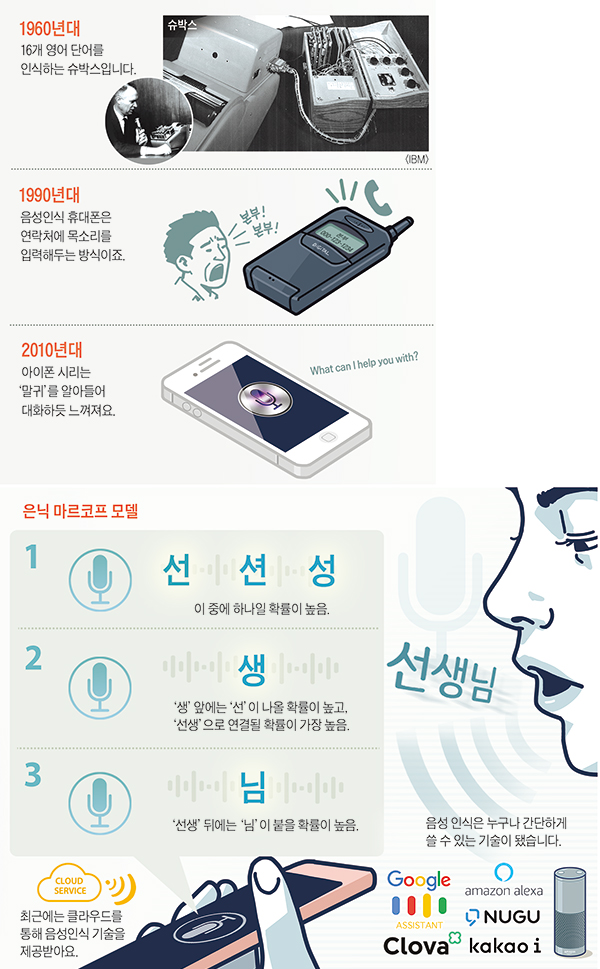

음성인식 기술은 마이크 등 소리 센서로 입력된 신호를 컴퓨터가 단어나 문장으로 변환하는 기술입니다. 최초의 음성인식 시스템은 1952년 미국 AT& T 벨 연구소가 개발한 단일 음성으로 말하는 숫자를 인식하는 '오드리(Audrey)'입니다. 이후 1963년 IBM에서 음성으로 16개 단어를 인식하고 계산할 수 있는 음성인식 기기 '슈박스(Shoebox)'를 공개했어요. 1970년대엔 미 국방부가 음성인식 기술을 전폭적으로 지원했습니다. 1971년 미 국방부에서 진행된 음성 이해 연구 프로그램은 음성인식 역사상 가장 큰 프로젝트로 3세 유아 어휘 수준인 1000여 단어를 이해할 수 있는 음성 이해 시스템 '하피(Harpy)'의 기반이 됐습니다.

◇대화하는 음성인식 비서

음성인식 기술은 마이크 등 소리 센서로 입력된 신호를 컴퓨터가 단어나 문장으로 변환하는 기술입니다. 최초의 음성인식 시스템은 1952년 미국 AT& T 벨 연구소가 개발한 단일 음성으로 말하는 숫자를 인식하는 '오드리(Audrey)'입니다. 이후 1963년 IBM에서 음성으로 16개 단어를 인식하고 계산할 수 있는 음성인식 기기 '슈박스(Shoebox)'를 공개했어요. 1970년대엔 미 국방부가 음성인식 기술을 전폭적으로 지원했습니다. 1971년 미 국방부에서 진행된 음성 이해 연구 프로그램은 음성인식 역사상 가장 큰 프로젝트로 3세 유아 어휘 수준인 1000여 단어를 이해할 수 있는 음성 이해 시스템 '하피(Harpy)'의 기반이 됐습니다.

-

- ▲ /그래픽=안병현

2010년 애플은 아이폰 4S와 함께 '시리(Siri)'라는 음성인식 기술을 개발했어요. 시리는 미리 녹음을 하거나, 몇 가지 제한된 명령어를 바탕으로 기기를 조작하는 게 아니라 우리의 언어를 그대로 받아들였습니다. '말귀'를 알아듣게 된 거죠. 날씨, 일정 관리, 검색, 메시지 읽기 등 다양한 기능을 수행했는데, 대화하듯 기능이 구현됐습니다.

2018년엔 구글의 CEO 순다르 피차이가 개발자 콘퍼런스에서 미용실 예약을 선보였습니다. 그런데 전화로 예약한 건 사람이 아니라 구글의 '듀플렉스'라는 기술이었습니다. 전화로 의사를 표현하고, 상대방과 적절한 시간까지 조율해 결정했습니다. 말이 너무 자연스러워서 상대방은 이 목소리가 컴퓨터가 내는 소리인지도 몰랐대요.

◇문장 통째로 학습

음성인식 기술의 바탕에는 음성 신호 처리와 자연어 처리 기술이 있습니다. 음성 신호 처리는 우리가 하는 말을 그대로 옮겨 적는 기술입니다. 컴퓨터는 우리의 목소리를 알아듣는 대신 소리 신호로 바꿔 기존에 녹음해 둔 데이터와 비교해 가면서 답을 찾아갑니다. 같은 음절, 같은 단어를 수없이 많이 학습해서 억양이나 속도, 높낮이의 변화에 대한 인식률도 높아지고 있어요.

예를 들면 '선생님'이라고 말하면 컴퓨터는 '선'뿐 아니라 '션', '성'처럼 확률적으로 비슷한 단어들을 함께 찾아두었다가 다음 음절인 '생'을 들어본 다음 앞글자와 확률적으로 가장 많이 연결되는 '선생'을 완성합니다. 그러고 나면 사람들이 보편적으로 맨 뒤에 '님'자를 붙이는 것을 예측하고 있다가 정말 이 소리가 입력되면 빠르게 확인해서 한 단어를 완성하는 방식이 많이 쓰입니다. 이 방법을 '은닉 마르코프 모델'이라고 부릅니다. 출력된 정보만을 가지고 숨겨진 상태를 추정한다고 해 붙여진 이름이에요.

음성 속에 들어 있는 의미를 읽는 것은 자연어 처리 기술에 맡겨야 해요. 예전에는 사전을 바탕으로 문장을 명사, 형용사, 서술어 등 문법적으로 쪼개서 의미를 읽어내는 방법을 썼는데, 컴퓨터와 인공지능 기술이 발전하면서 요즘은 문장을 통째로 학습합니다.

최근에는 앞뒤 문맥을 함께 읽어서 사람이 전체적으로 무슨 말을 하려고 하는지 맥락을 파악하는 등 기술이 빠르게 발전하고 있습니다. 이 인공지능 기반의 자연어 처리 기술이 효과를 내는 것은 사람의 음성 속에 들어 있는 묘한 뉘앙스와 관계가 있습니다. 자연어 처리 인공지능 모델을 살펴보면 '예' '아니요' 같은 아주 단순한 단어에 대한 학습도 정교하게 이뤄집니다. 우리가 이 간단한 단어 하나에 얼마나 여러 가지 감정을 담아내는지를 생각해보면 이해가 될 거예요. 사투리를 알아듣는 음성인식 기술도 개발하고 있습니다. 경상도 사투리 "마, 양무시나 사 묵어래"라고 말하면 "그냥 당근이나 사 먹어라"라고 알아듣는 거죠. 농담 삼아 우리말 자연어 처리 기술의 완성은 사투리를 컴퓨터가 알아들어야 한다는 이야기를 하기도 해요.

◇일상이 된 음성인식

음성인식은 이제 누구나 간단하게 쓸 수 있는 기술이 됐습니다. 클라우드 덕분입니다. 아마존, 구글 등 IT 회사가 운영하는 클라우드 안에 음성인식에 대한 인공지능 도구들이 포함돼 있습니다. 클라우드 회사들이 지속적으로 막대한 데이터로 학습시키기 때문에 더 말을 잘 알아듣게 진화하고 있습니다.

이제 음성인식 기술은 일상의 한 부분이 됐어요. 애플의 시리나 구글 어시스턴트, 그리고 아마존 알렉사뿐 아니라 국내에서 개발한 네이버 클로바나 카카오 아이, SK 누구 등 다양한 음성인식 기술이 시중에 나오고 있어요. 스마트폰뿐 아니라 스피커, 자동차, 냉장고, 홈 네트워크로 범위가 다양해지고 있어요. 발음이 어려운 언어 장애인들의 목소리를 대신 알아듣고 정확한 의사 전달을 할 수 있는 기술도 개발됐습니다. 이제 누구의 목소리인지 구분해서 맞춤 정보를 받고 쇼핑과 결제도 말로 처리합니다. 음성인식이 목소리 속의 감정을 읽어서 적절한 조명과 음악을 맞춰주는 감정 인식 기술도 개발 단계입니다.

이제 목소리로 "거실에 전등 켜줘" "운전할 때 듣기 좋은 음악 틀어줘"라고 말하는 것이 놀랍지 않아요.